REACH : le long chemin vers la co-créativité humain-machine

Gérard Assayag, Marc Chemillier © Jeff Joly

Gérard Assayag, Marc Chemillier © Jeff Joly

Revenons à la genèse du projet: comment est née cette idée d’improviser avec une machine ?

Tout est parti de l’arrivée dans l’équipe Représentations musicales, à la fin des années 1990, de Shlomo Dubnov, chercheur israélo-américain venu faire son post-doc à l’Ircam. La spécialité de Shlomo était la théorie de l’information. Il s’intéressait notamment à la notion de «style musical» – au sens de certaines idiosyncrasies que l’on peut repérer dans un genre musical donné, chez un musicien ou un compositeur. Son idée était que les principes computationnels de la théorie de l’information moderne pourraient capter certaines structures de ce «style musical». À l’époque, notre équipe était complètement dévolue à la notion de création via l’utilisation d’outils computationnels. Pour la composition d’abord, avec OpenMusic, puis de plus en plus pour la création instantanée, dans l’interaction et l’improvisation, avec la contribution inestimable de Carlos Agon. Dans l’équipe, il y avait également Marc Chemillier, mathématicien et anthropologue qui, avec sa culture plus jazzistique, avait encore une autre obsession : reproduire, avec la machine, la notion de swing, associée aux complexités harmoniques du jazz. Une quatrième personne a été déterminante dans ce qu’est devenu le projet: Georges Bloch, qui n’aimait pas le son MIDI des premières expériences et développa les tout premiers composants audio des logiciels. Je développais de mon côté l’idée d’une intelligence artificielle créative, au moyen d’algorithmes génératifs et d’architectures d’agents autonomes, et j’eus la chance d’introduire à ce moment en informatique musicale un formalisme issu des recherches sur le génome, qui permettait la modélisation statistique de séquences symboliques complexes, «l’Oracle des facteurs», qui deviendra le modèle central de mémoire musicale active, aussi bien pour l’écoute que pour la génération, de toute la série de logiciels d’improvisation. Tous les éléments étaient en place pour la naissance d’OMax. À nous quatre, nous sommes devenus les «OMax Brothers», le groupe fondateur de ce paradigme d’improvisation et de technologie que l’on retrouvera dans toute la généalogie de logiciels, jusqu’aux plus récents Dyci2 et Somax2 en passant par ImproteK (devenu Djazz).

Comment fonctionne OMax ?

Une métaphore que j’aime employer est celle de la carte et du territoire. L’idée est la suivante : le style musical est comme un territoire – pour la musique classique par exemple, les différentes tonalités seraient autant de paysages, le rythme, des accidents dans le relief, etc. Quand un musicien joue, ou quand il improvise, il emprunte un chemin dans ce paysage et, ce faisant, il en dévoile une partie – nécessairement limitée. À partir des chemins empruntés par le musicien, OMax va tenter de se constituer une cartographie de l’intégralité – potentielle – du territoire parcouru. C’est ainsi que travaille OMax: à partir d’une instance parmi des milliers, il infère le style, ou plutôt la structure globale qui donne l’idée du style. Après quoi, il joue : c’est-à-dire qu’il se promène à son tour dans la carte qu’il a lui-même dessinée. Ce qui explique que ce qu’il joue ressemble à ce dont on l’a nourri, formant comme des variations inédites et cohérentes. La version de concert d’OMax a été ré-écrite et optimisée plus tard par Benjamin Lévy dans le cadre de sa thèse de doctorat.

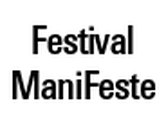

Le logiciel Somax2

Le logiciel Somax2

Vous parlez de « généalogie » : les logiciels suivants ne sont donc pas des améliorations successives d’OMax ?

Non. Car l’improvisation a bien des facettes et OMax n’en reproduit que certaines – au début, c’était même très élémentaire. Certes, OMax écoute pour apprendre mais, quand il joue, c’est de manière obstinée, sans écouter le musicien. Il se promène dans le modèle, sans s’adapter aux changements de son environnement sonore. Il n’interagit pas au sens propre du terme. Bien sûr, dans les faits, le musicien peut, lui, s’adapter à ce que produit la machine, en la contredisant ou en allant dans son sens – réaction que la machine va de nouveau apprendre, enrichissant constamment son discours… et tout cela donne une illusion de dialogue, de synchronicité et d’interaction. Les autres logiciels vont se définir par rapport aux manques d’OMax. On en a très vite identifié deux principaux. Première lacune : la planification. L’improvisation peut se faire dans deux contextes: idiomatique (jazz, baroque, etc.), ou non (totalement libre). Dans le premier cas, elle doit suivre un scénario temporel qui peut être rigide. C’est ce qui a donné ImproteK puis Djazz, qui produisent un discours tributaire de contraintes idiomatiques (grille harmonique, pulsation, rythme, etc.). Deuxième lacune : la réactivité. Quand il se balade dans sa cartographie, OMax est très conscient des structures du territoire qu’il est en train d’explorer: il s’écoute lui-même pour faire ses propres choix. C’est de l’auto-écoute. Mais il est sourd au monde extérieur. Ce qu’il produit est indépendant du contexte immédiat.

« Si on veut que le logiciel réagisse au monde extérieur et contexte immédiat, il faut une vraie écoute extérieure, qui l’influence dans l’instant. C’est ce que fait Somax: il tente en permanence de réconcilier sa cartographie (apprise à partir des musiques dont on le nourrit) et celle inférée du jeu du musicien, pour tisser un parcours cohérent entre les deux. »

Nous nous sommes inspirés pour cela du principe des cartes corticales issu des neurosciences – une idée apportée par Laurent Bonnasse-Gahot alors en post-doc dans l’équipe qui travailla sur les toutes premières versions de Somax. Si quelqu’un sifflote le début d’un air que je connais, cela « active » immédiatement plusieurs régions de ma mémoire, ce qui va me permettre de continuer l’air, ou du moins d’anticiper la suite, et quelquefois de créer une variation de l’original. C’est exactement le fonctionnement de Somax: lorsqu’il reconnaît un motif, il va chercher dans sa cartographie les paysages qui s’en rapprochent, les active (comme des neurones «s’allument» dans le cerveau) pour se promener ensuite autour de ces «locus». Et il est capable de le faire sur toutes les dimensions du discours: mélodie, harmonie, rythme, timbre, intensité, etc.

Une installation Somax2 dans laquelle des agents autonomes s’écoutent et dialoguent entre eux dans un hommage aux grands maîtres du XXe siècle

Peut-on dire que les derniers instants du discours musical lui fournissent presque le « scénario » qu’il doit suivre, comme dans ImproteK?

Non. C’est en revanche ce que Dyci2 rendra possible, en introduisant la notion de «microscénario ». Le projet Dyci2 est né de la volonté de réunir les fonctionnalités d’OMax, Somax et ImproteK en un seul logiciel – projet qui a été pris en charge par Jérôme Nika pendant son post-doc. Cependant, c’était trop optimiste, et il en a finalement résulté… un nouveau paradigme d’interaction, implémentant la notion de microscénario réactif. Cette approche assez compositionnelle (il faut écrire ces scénarios) permet d’installer des interactions sophistiquées, demandant une certaine préparation, donc moins spontanées dans l’improvisation que Somax, mais avec leur richesse propre.

Les quatre logiciels ont donc des fonctionnalités différentes ?

Chacun évoque un paradigme d’attention et d’interaction particulier, comme un aspect distinct du cerveau improvisateur, et on peut les utiliser en parallèle au sein d’une même session musicale pour mieux reproduire la complexité du comportement humain. Ces logiciels sont hyper-spécialisés dans leurs fonctionnalités et leur interface.

Comme des voitures : de course, de rallye ou de tourisme, elles roulent toujours mais ne permettent pas les mêmes choses.

Exactement, et elles sont excellentes chacune dans son domaine.

Quelles sont aujourd’hui les différentes pistes de recherche ?

Quelles sont aujourd’hui les différentes pistes de recherche ?

Trois voies prospectives se dégagent sur le long terme. La première a en réalité été initiée dans les années 1980 par George Lewis avec Voyager. Aujourd’hui, les agents improvisateurs dans nos logiciels ne se perçoivent pas comme un collectif. Dans Voyager, les agents génératifs étaient organisés socialement, avec des agents coordinateurs qui aidaient à la prise de décision et à départager des visions parfois contradictoires. Les développements de l’IA pourraient nous permettre aujourd’hui d’aller plus loin, en implémentant cette dimension sociale via des mécanismes d’apprentissage neuronal, notamment profond (« deep learning »), qui permettraient d’apprendre des comportements joints difficiles à spécifier ou à formaliser. Ce principe serait très riche pour développer différents aspects, notamment donner une dimension spatiale aux interactions ou leur conférer un caractère plus «instrumental», une dimension qu’explore Mikhaïl Malt dans l’équipe. En effet, en s’adressant à ces agents de plus haut niveau, on pourrait contrôler de manière simple des comportements complexes et rendre plus vivante la performance sur ordinateur. La deuxième voie de recherche concerne l’autonomie des agents improvisateurs. Aujourd’hui, la machine écoute un signal A et en déduit un signal B, mais c’est le manipulateur du logiciel qui impulse les grandes directions esthétiques et réoriente si le résultat n’est pas satisfaisant. Mais comment faire en sorte que ce signal B ait un intérêt musical de manière autonome ? Cela peut notamment passer par ce qu’on appelle l’apprentissage par renforcement. C’est la méthode qui a permis aux ordinateurs d’être très forts aux échecs et au go. Mais, pour cela, il faut pouvoir donner à la machine une idée de la qualité de ce qu’elle produit!

Le logiciel Voyager utlisé par George Lewis

« Dans les jeux, on gagne ou non et c’est ce qui conditionne le renforcement des comportements favorables. Mais comment définir une «stratégie gagnante» en art, sans se fermer des possibilités esthétiques qu’on aimerait indéfiniment ouvertes? Sur quels critères objectifs de jugement s’appuyer? »

L’une de nos idées est que la réaction du musicien à la machine peut aider: par exemple, s’il reprend les propositions de la machine, c’est peut-être que ça lui plaît… Mais comment quantifier cela ? Le troisième champ de recherche est encore un peu théorique et technique. Jusqu’ici, nous avons exploré des systèmes de modélisation statistique, en utilisant des ensembles de mémoire constitués – nous faisons une sorte de granulation à très gros grains, qui permet de capturer beaucoup de la richesse musicale et des articulations instrumentales des matériaux appris par la machine. On n’a donc pas besoin de réinventer cette richesse : ce sont plutôt les nouvelles trajectoires qu’on invente. D’un autre côté, l’apprentissage neuronal profond permet d’interpoler dans un espace continu (l’«espace latent») et donc de créer des objets littéralement «inouïs», mais qui ont plus de mal à avoir une cohérence globale et une qualité sonore satisfaisante. Ne peut-on avoir le meilleur des deux mondes et faire marcher ensemble ces deux régimes? C’est l’objet de recherches intensives qui ont lieu dans le projet REACH qui fédère aujourd’hui toutes nos recherches autour de la co-créativité musicien-machine. REACH met en avant la notion de co-créativité comme phénomène d’« émergence » dans le système complexe formé par le musicien et la machine, système dans lequel chacun écoute, apprend constamment de l’autre et développe un parcours adaptatif. Ainsi, des formes musicales jointes apparaissent, qui ne se réduisent ni à l’action de l’un ni à celle de l’autre mais n’existent que dans l’être fugitif de l’interaction. C’est donc un tout nouvel univers qui s’offre désormais à l’imagination.

L’une de nos idées est que la réaction du musicien à la machine peut aider: par exemple, s’il reprend les propositions de la machine, c’est peut-être que ça lui plaît… Mais comment quantifier cela ? Le troisième champ de recherche est encore un peu théorique et technique. Jusqu’ici, nous avons exploré des systèmes de modélisation statistique, en utilisant des ensembles de mémoire constitués – nous faisons une sorte de granulation à très gros grains, qui permet de capturer beaucoup de la richesse musicale et des articulations instrumentales des matériaux appris par la machine. On n’a donc pas besoin de réinventer cette richesse : ce sont plutôt les nouvelles trajectoires qu’on invente. D’un autre côté, l’apprentissage neuronal profond permet d’interpoler dans un espace continu (l’«espace latent») et donc de créer des objets littéralement «inouïs», mais qui ont plus de mal à avoir une cohérence globale et une qualité sonore satisfaisante. Ne peut-on avoir le meilleur des deux mondes et faire marcher ensemble ces deux régimes? C’est l’objet de recherches intensives qui ont lieu dans le projet REACH qui fédère aujourd’hui toutes nos recherches autour de la co-créativité musicien-machine. REACH met en avant la notion de co-créativité comme phénomène d’« émergence » dans le système complexe formé par le musicien et la machine, système dans lequel chacun écoute, apprend constamment de l’autre et développe un parcours adaptatif. Ainsi, des formes musicales jointes apparaissent, qui ne se réduisent ni à l’action de l’un ni à celle de l’autre mais n’existent que dans l’être fugitif de l’interaction. C’est donc un tout nouvel univers qui s’offre désormais à l’imagination.

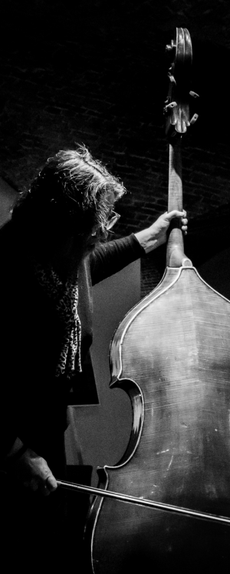

Joëlle Léandre © Geert Vandepoele

Propos recueillis par Jérémie Szpirglas, écrivain