Compositeur, designer sonore, et enseignant et chercheur en musique électronique à la Guildhall School of Music and Drama de Londres, Seth Scott explore, dans le cadre de sa résidence en recherche artistique à l’Ircam au sein de l’équipe Analyse et synthèse des sons du laboratoire STMS, la politique et la poétique de la parole synthétisée.

Le rêve n’est pas nouveau : déjà, au temps des Pharaons, les égyptiens faisaient « parler » des statues. Plus tard, Homère décrivit ce qui ressemble diablement à des automates parlants, confectionnés par le dieu Héphaïstos, et, au IIIe siècle, des savants tels Philon de Byzance, Ctésibios ou Héron d’Alexandrie donnèrent naissance aux premières machines, qu’on voulut aussitôt faire parler. La résidence en recherche artistique de l’Anglais Seth Scott s’inscrit délibérément dans cette longue histoire. Habitué des projets mixtes, interactifs et non conventionnels, pour l’image ou taillés sur mesure pour des espaces d’exposition, Seth Scott se concentre depuis plusieurs années sur un projet qui relève au moins autant de l’histoire de l’art et des techniques que de la composition. Il s’intéresse en effet aux machines parlantes, et notamment à ses avatars contemporains : la synthèse de la parole grâce aux nouveaux modèles d’apprentissage machine, souvent qualifiés de manière abusive « d’intelligence artificielle ».

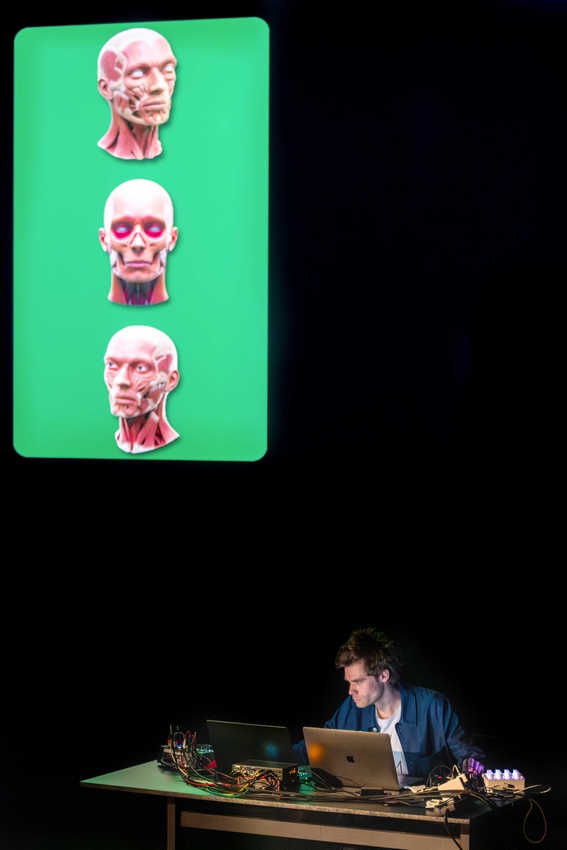

Crédits photo 1 et 2 : Performance de Seth Scott au MO Museum de Vilnius © Tomas Terekas

Crédits photo 1 et 2 : Performance de Seth Scott au MO Museum de Vilnius © Tomas Terekas

« Je me suis immergé dans l’histoire de la reproduction de la voix humaine. Dès le début de mes recherches, j’ai été étonné de l’ancienneté des premières tentatives de synthèse de la parole. Cela remonte en effet à la Haute Antiquité, à l’instar des Colosses de Memnon qui, selon certains auteurs, émettaient le son d’une voix humaine. Cet intérêt pour la synthèse de la parole se retrouve également dans mon travail. Mes pièces ont en effet bien souvent trait au parler : je m’intéresse au mot dit, au texte mis en musique… J’ai ainsi composé, pour une organisation de la City de Londres, une pièce qui consiste en une visite guidée (avec un narrateur à la fiabilité douteuse), qui va d’un marché à viande au London Stock Exchange, explorant les parallèles parfois assez peu évidents entre les deux. »

« Ce qui m’intéresse, ce sont autant les technologies que le rapport que l’on entretient avec elles, qui tient parfois plus de désirs, de fantasmes ou de peurs, que de réalités – et ce bien avant l’apparition récente de l’intelligence artificielle. Cette histoire dit beaucoup de l’évolution de notre rapport au savoir lui-même, ainsi que de notre compréhension du phénomène physique de la voix. On observe en effet que, à chaque époque, les machines parlantes s’appuient sur ce que l’on croit alors être le fonctionnement de la parole. La conception des premiers automates, à l’époque baroque, accompagne ainsi les grandes découvertes anatomiques, et les ingénieurs d’alors tentent de reproduire les différents éléments que les médecins imaginent permettre la parole. Au XIXe siècle se développe la science de l’acoustique, et les machines s’appuient alors sur cette connaissance nouvelle de la nature physique du son : on reproduit la voix en tentant de comprendre la manière dont elle sonne. Avec l’apprentissage machine, on revient à une approximation que je qualifierais d’anatomique, même s’il ne s’agit plus aujourd’hui de modéliser le fonctionnement des cordes vocales et du larynx mais bien celui du cerveau. D’une certaine manière, on revient donc à la méthode assez crue qui avait cours à l’époque baroque. » C’est dans ce contexte que Seth Scott découvre l’appel à résidence en recherche artistique de l’Ircam : « J’avais déjà utilisé des outils développés à l’Ircam, comme le fantastique moteur de synthèse par apprentissage machine RAVE, mais j’avais bien conscience de ne pas être à jour, du point de vue des derniers développements technologiques. Avant même de commencer la résidence proprement dite, j’ai pu discuter avec Axel Roebel de nos attentes respectives, des défis à relever, et de la dimension expérimentale des logiciels conçus ici. » En arrivant en studio, toutefois, la plus grande surprise qui attend Seth, c’est le raffinement de ces nouveaux outils. « Ils ne sont pas tous parfaitement fonctionnels, constate-t-il, mais ils sont capables d’accomplissements complètement fous ! Neuf fois sur dix, quand je demande à la machine de dire quelque chose, elle le fait. Ce fut presque une déception pour moi : c’était presque trop proche d’une voix réelle. »

C’est dans ce contexte que Seth Scott découvre l’appel à résidence en recherche artistique de l’Ircam : « J’avais déjà utilisé des outils développés à l’Ircam, comme le fantastique moteur de synthèse par apprentissage machine RAVE, mais j’avais bien conscience de ne pas être à jour, du point de vue des derniers développements technologiques. Avant même de commencer la résidence proprement dite, j’ai pu discuter avec Axel Roebel de nos attentes respectives, des défis à relever, et de la dimension expérimentale des logiciels conçus ici. » En arrivant en studio, toutefois, la plus grande surprise qui attend Seth, c’est le raffinement de ces nouveaux outils. « Ils ne sont pas tous parfaitement fonctionnels, constate-t-il, mais ils sont capables d’accomplissements complètement fous ! Neuf fois sur dix, quand je demande à la machine de dire quelque chose, elle le fait. Ce fut presque une déception pour moi : c’était presque trop proche d’une voix réelle. »

« Cette qualité des résultats amenait une nouvelle interrogation, d’ordre plus philosophique, ou éthique. Si les résultats étaient si bons qu’ils s’approchaient véritablement de ce qu’on pourrait faire avec un.e comédien.ne, en avais-je réellement besoin d’un point de vue créatif ? Ce d’autant plus que, comme toute technologie, l’apprentissage machine n’est pas neutre : il s’accompagne même d’implications politiques et éthiques franchement inquiétantes. Il me fallait donc une motivation claire pour l’utiliser : pas question de faire avec le machine learning ce que je pouvais faire autrement, en évitant de surcroit son énorme impact écologique et social. » Ce nouveau défi est d’autant plus complexe à relever que, contrairement à d’autres technologies, le machine learning suit des lois probabilistes, générant un résultat médian, donc banal et sans aspérité.

« On connaît bien l’esthétique du « glitch », que l’on peut travailler en détournant un outil technique, comme des filtres ou des plugins. Ici, il m’a fallu découvrir comment faire apparaître ces « accidents ». Mon premier réflexe a été d’utiliser un modèle pour produire des formats de données sur lesquels il n’avait pas été entraîné. On peut aussi jouer avec le côté « probabiliste » des modèles. Dans la première version de mon script, la seule chose que je pouvais mettre dans mon « prompt » (c’est-à-dire la demande formulée), c’était le texte dit, pas le ton de la voix. Je me suis ainsi aperçu que le contenu d’un texte pouvait déterminer le timbre de la voix générée : si je fais dire à la machine « Il était une fois », il y a de fortes chances pour que la voix produite ait les inflexions d’un conteur. Pareil pour des textes universitaires… On peut ainsi mettre en lumière certains biais dans les bases de données. »

« Dans une seconde version de mon script, je pouvais spécifier un texte et un échantillon audio comme modèle. J’ai ainsi pu générer une parole en contradiction avec son contexte sonore et le ton de sa voix, ce qui produit des choses très intéressantes, surtout quand ma demande ne correspondait pas aux caractéristiques typiques des données d’entraînement. »

Seth Scott a poussé loin la torture du logiciel, en exigeant de lui des extrêmes en termes d’endurance ou d’identité genrée, ou en écrivant des rythmiques à l’aide de séquences textuelles. La dernière version du modèle développée par l’équipe Analyse et synthèse des sons permet également de jouer avec l’émotion de la voix – mais son paramétrage est encore au stade expérimental.

À terme, l’objectif est évidemment de composer de la musique à partir de ce travail. « J’ai commencé par des esquisses. Je ne suis pas de ces compositeurs qui peuvent créer à partir de rien ; j’ai besoin générer du matériau, souvent bien plus que ce dont j’ai besoin, voire bien plus que ce que je peux humainement traiter. Et c’est ce matériau que je recompose. Pour l’instant, je me contente de petits fragments, car l’une des limitations du logiciel est qu’il n’est capable de générer que 30 secondes de parole maximum – les chercheurs de l’équipe continuent évidemment à le développer pour en faire davantage. Le gros problème, c’est que le logiciel a besoin de se « rappeler » ce qu’il a déjà produit afin de produire la suite, ce qui signifie que, plus ce qui est demandé est long, plus c’est compliqué. Mais ce n’est finalement pour moi qu’une contrainte structurelle, que je peux contourner. »

Seth Scott déploie des outils d’apprentissage machine à trois moments clés de son processus de création. D’abord, pour générer du code informatique :

« Il m’arrive d’utiliser des modèles (comme ChatGPT) pour développer mes propres programmes en Python par exemple, explique le compositeur. Mais j’utilise beaucoup Max, même si son environnement n’est pas prévu pour traiter le langage. »

Vient ensuite la génération du contenu sémantique, les logiciels qu’il conçoit pouvant par exemple réassembler les mots de bases de données existantes, qui ont servi à entraîner certains modèles (comme ceux développés par l’équipe Analyse et synthèse des sons). La dernière étape est évidemment la génération du son en lui-même. Chaque étape exige un travail à la fois sur les bases de données et sur l’écriture algorithmique – un travail duquel les problématiques de propriété intellectuelle ne sont pas absentes, bien au contraire.

« J’aime jouer avec les bases de données. J’en utilise même qui ont servi par le passé à mettre au point des moteurs de synthèse de la parole datant d’avant l’IA. »

Et si tous ces processus, parfois très lourds, occupent l’essentiel de son temps de recherche et de composition, une autre interrogation pointe le bout de son nez, peut-être bien plus essentielle : « Les technologies que nous utilisons sont très avant-gardistes, à la pointe du progrès, mais toute technologie vieillit inévitablement : comment vieillira la pièce que j’aurai composée ? »

Jérémie Szpirglas